分析背景

注册用户近4W人,最高峰活跃用户过2W,日常活跃用户过1W,通过nginx日志分析记录用户流量及系统负载等。系统采用3台nginx轮询负载,故三台流量均衡,取流量最高日进行分析。

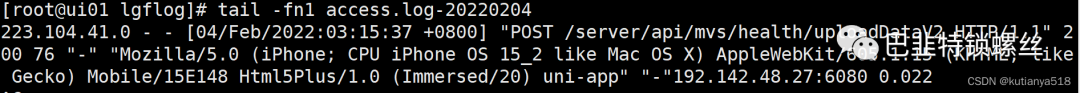

日志格式如下所示:

系统数据:单表最大6g,单条数据根据表结构不同最大1.3k,最小0.18k,平均每天占用磁盘空间17G左右,表数据日最高:血压表近6W,佩戴状态表420W,心率表520W,呼吸率表560W,睡眠表27W,血氧表500W,运动表1500W,温度表600W,轨迹表16W

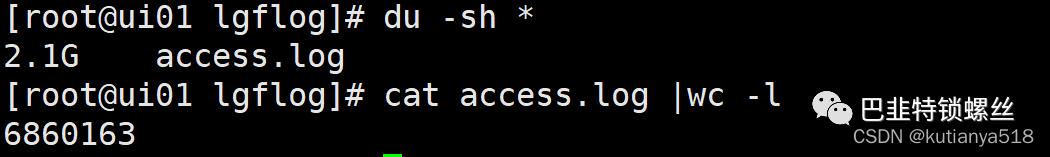

PV:日最高可达2000W

IP数量:日最高可达1.8W

系统并发:秒级可达4K 分级可达4W

通过ip相关统计可在系统突发流量异常情况下,分析是否受到攻击

页面访问统计及性能分析:可根据api访问频率及响应时间,优化对应接口,提高系统性能

一、统计PV,UV数

1、统计所有的PV数

cat access.log | wc -l

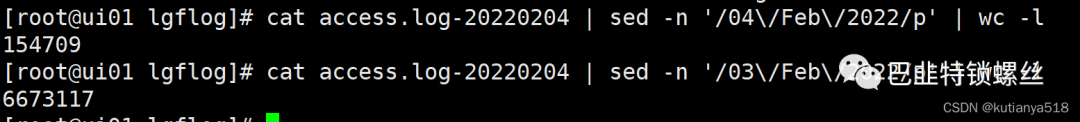

2、统计指定某一天的PV数

cat access.log-20220204 | sed -n '/03/Feb/2022/p' | wc -l

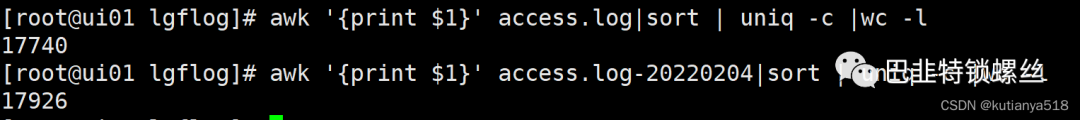

3、根据访问IP统计UV--近1.8W

awk '{print $1}' access.log|sort | uniq -c |wc -l

二、IP相关统计

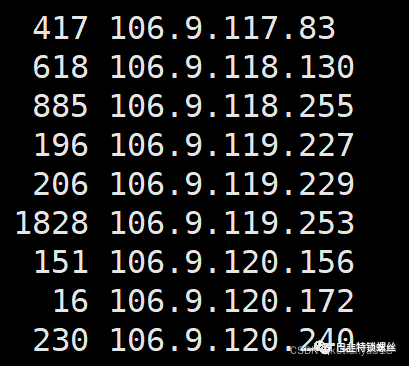

1、统计每个IP访问次数

awk '{print $1}' access.log|sort | uniq -c

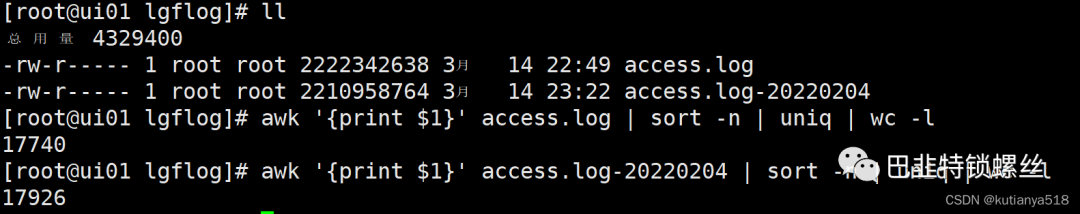

2、统计IP访问量(独立ip访问数量)--近1.8W独立IP

awk '{print $1}' access.log | sort -n | uniq | wc -l

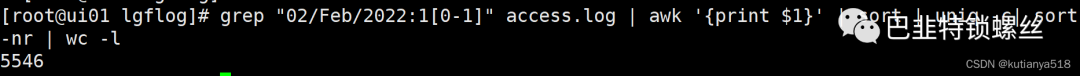

3、查看某一时间段的IP访问量(10-11点)

grep "02/Feb/2022:1[0-1]" access.log | awk '{print $1}' | sort | uniq -c| sort -nr | wc -l

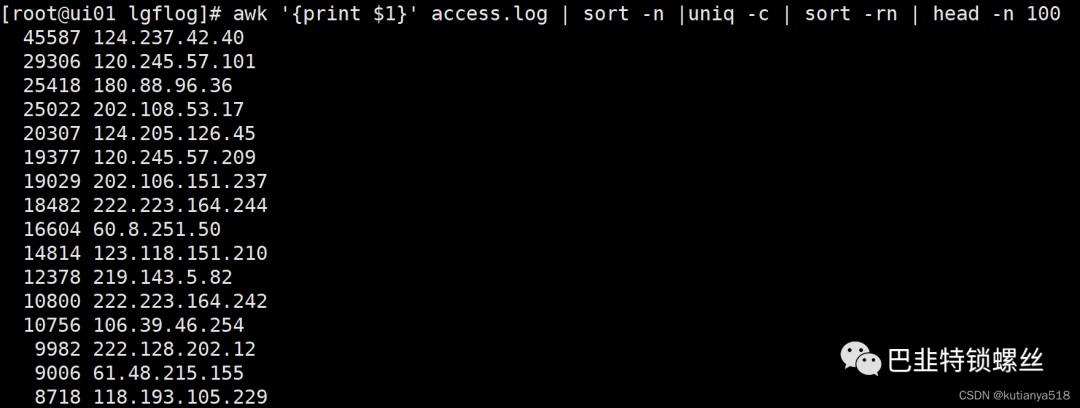

4、查看访问最频繁的前100个IP

4、查看访问最频繁的前100个IP

awk '{print $1}' access.log | sort -n |uniq -c | sort -rn | head -n 100

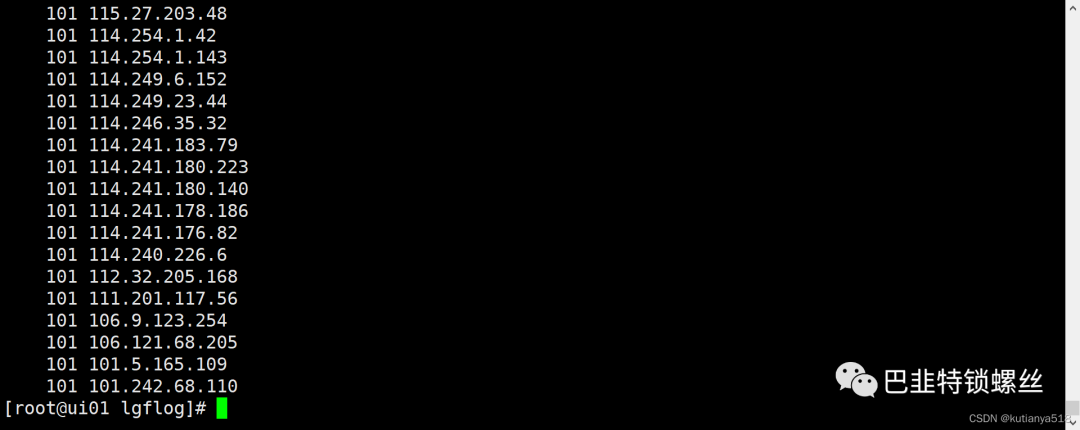

5、查看访问100次以上的IP

awk '{print $1}' access.log | sort -n |uniq -c |awk '{if($1 >100) print $0}'|sort -rn

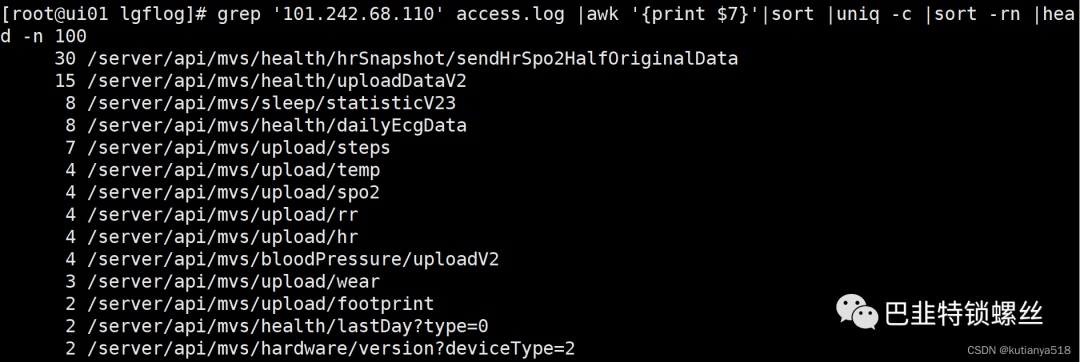

6、查询某个IP的详细访问情况,按访问频率排序

grep '101.242.68.110' access.log |awk '{print $7}'|sort |uniq -c |sort -rn |head -n 100

三、页面访问统计

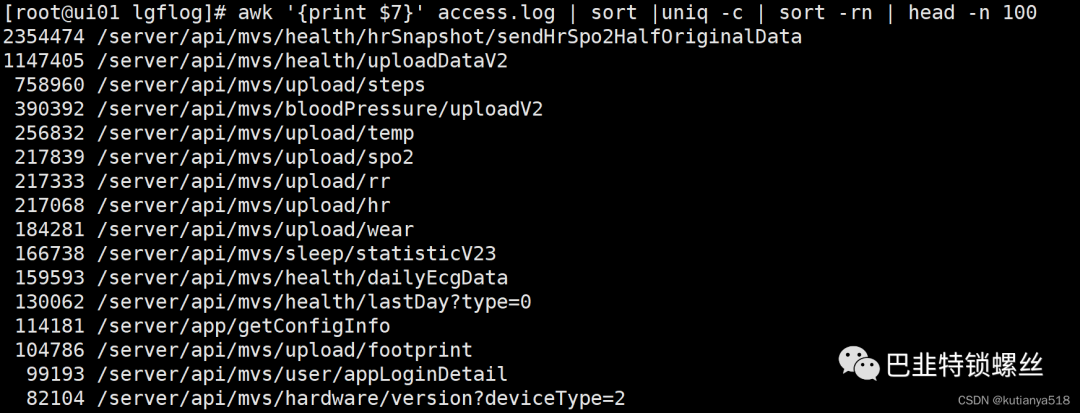

1、查看访问最频的api(TOP100)

awk '{print $7}' access.log | sort |uniq -c | sort -rn | head -n 100

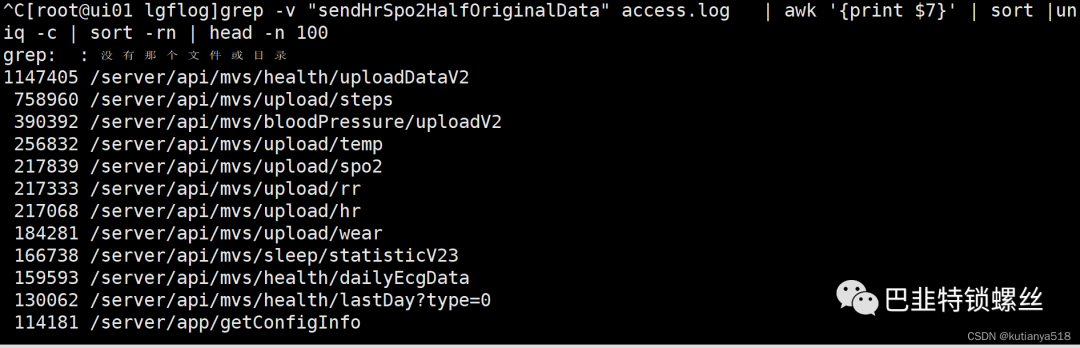

2、查看访问最频的页面([排除sendHrSpo2HalfOriginalData接口】(TOP100)

grep -v "sendHrSpo2HalfOriginalData" access.log | awk '{print $7}' | sort |uniq -c | sort -rn | head -n 100

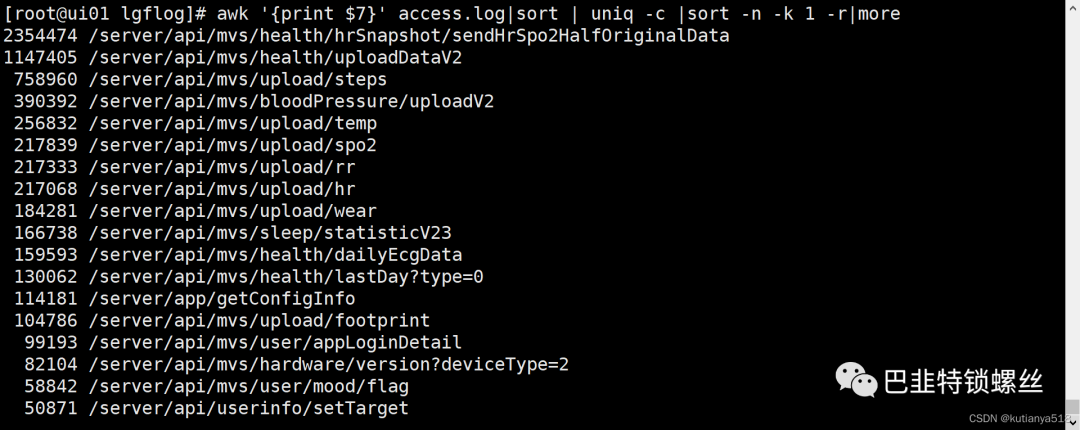

3、查询访问最频繁的api

awk '{print $7}' access.log|sort | uniq -c |sort -n -k 1 -r|more

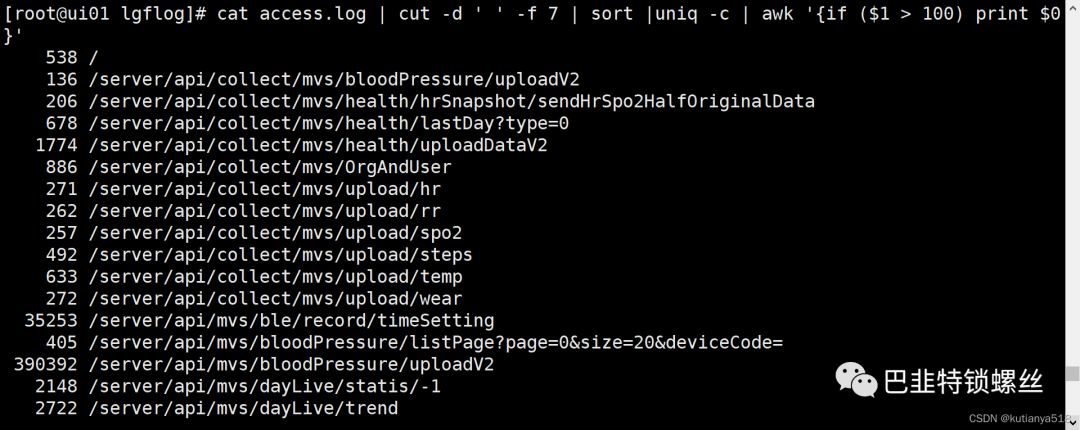

4、查看页面访问次数超过100次的api

cat access.log | cut -d ' ' -f 7 | sort |uniq -c | awk '{if ($1 > 100) print $0}' |less

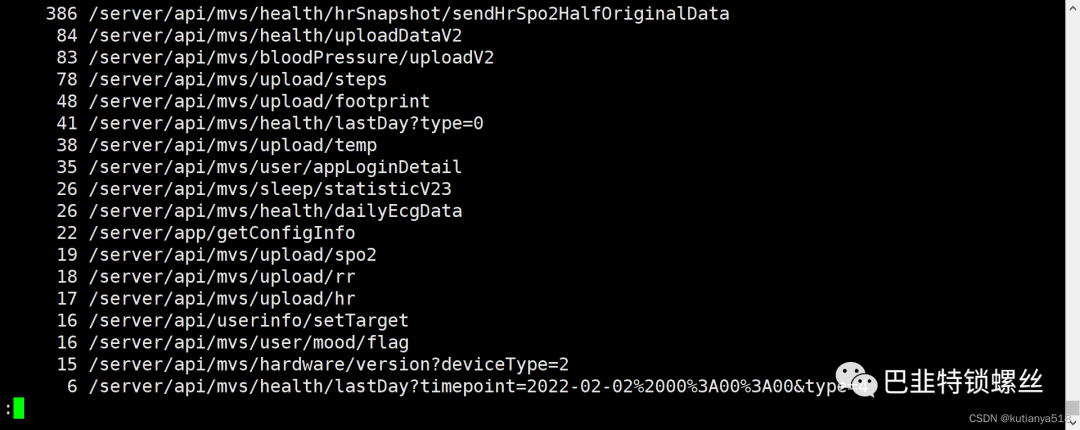

5、查看最近1000条记录,访问量最高的页面

tail -1000 access.log |awk '{print $7}'|sort|uniq -c|sort -nr|less

四、每秒每分钟每小时请求量统计

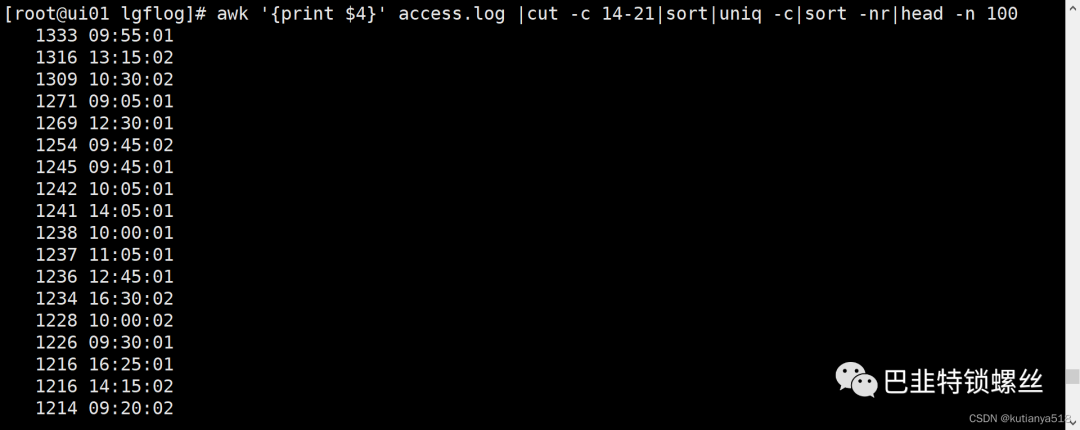

1、统计每秒的请求数,top100的时间点(精确到秒)--近4k并发

awk '{print $4}' access.log |cut -c 14-21|sort|uniq -c|sort -nr|head -n 100

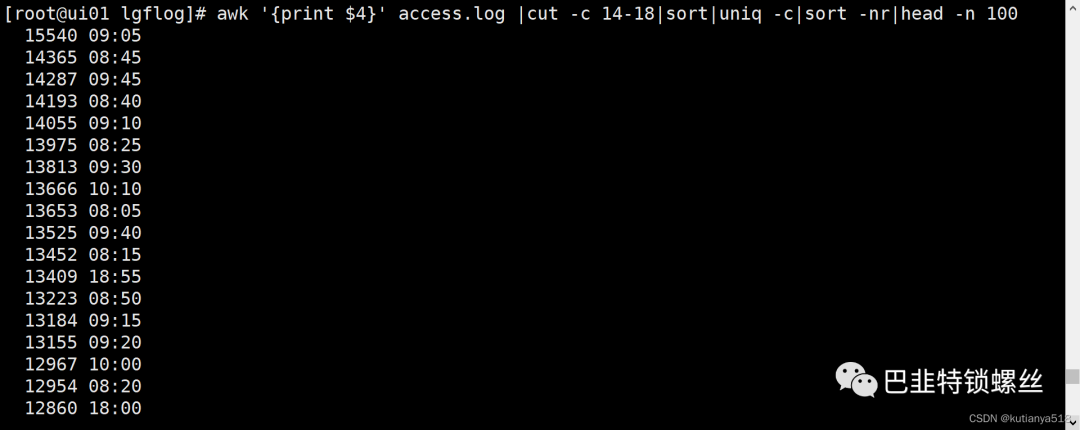

2、统计每分钟的请求数,top100的时间点(精确到分钟)

awk '{print $4}' access.log |cut -c 14-18|sort|uniq -c|sort -nr|head -n 100

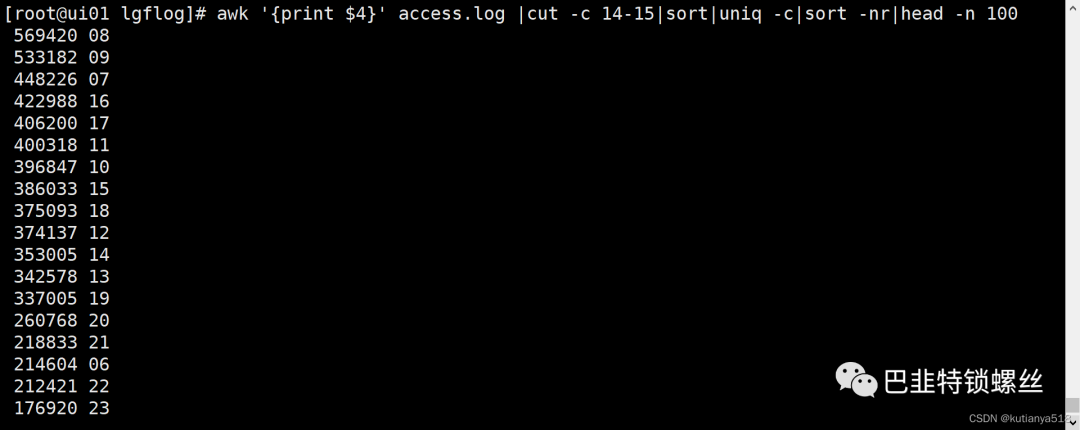

3、每小时的请求数,top100的时间点(精确到小时)

awk '{print $4}' access.log |cut -c 14-15|sort|uniq -c|sort -nr|head -n 100

五、性能分析

*在nginx log中最后一个字段加入$request_time

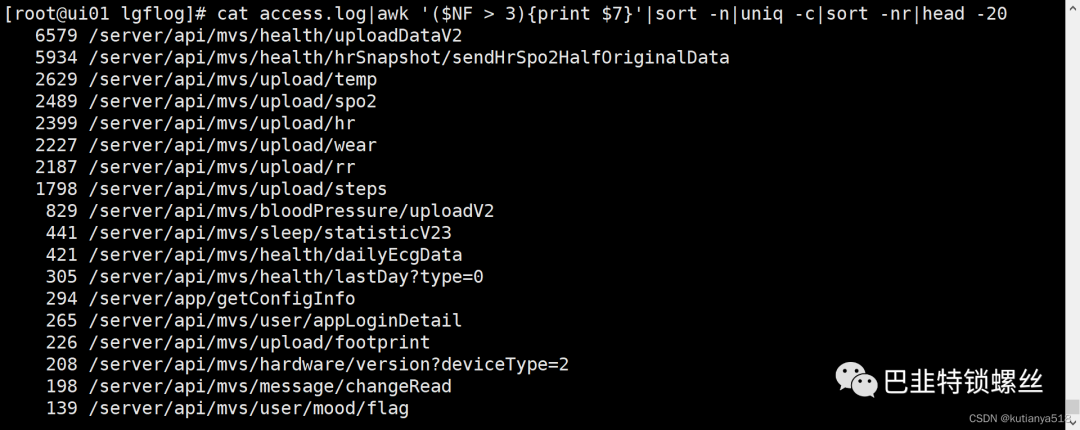

1、列出传输时间超过 3 秒的页面,显示前20条

cat access.log|awk '($NF > 3){print $7}'|sort -n|uniq -c|sort -nr|head -20

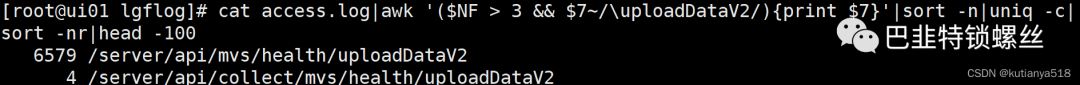

2、列出uploadDataV2请求时间超过3秒的页面,并统计其出现的次数,显示前100条

cat access.log|awk '($NF > 3 && $7~/uploadDataV2/){print $7}'|sort -n|uniq -c|sort -nr|head -100

版权声明:本文内容来自CSDN:kutianya518,遵循CC 4.0 BY-SA版权协议上原文接及本声明。本作品采用知识共享署名-非商业性使用-禁止演绎 2.5 中国大陆许可协议进行可。原文链接:https:如有涉及到侵权,请联系,将立即予以删除处理。在此特别鸣谢原作者的创作。此篇文章的所有版权归原作者所有,与本公众号无关,商业转载建议请联系原作者,非商业转载请注明出处。

4、查看访问最频繁的前100个IP

4、查看访问最频繁的前100个IP